如何有效利用MapReduce框架中的HashMap来优化数据处理?

优化策略概述

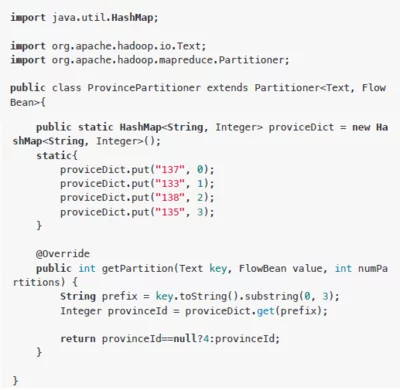

在MapReduce框架中,虽然官方推荐使用HashFunction进行分区,但在实践中,我们通常使用HashMap来进行分区和排序。

1. 合理设置分区参数

在MapReduce中,分区的方式对于整体的执行效率有着至关重要的影响。如果我们的输入数据量非常大,那么合理的分区可以使整个计算过程更加高效。在实际应用中,我们可以根据数据的分布特性来设置分区参数,例如,我们可以通过自定义分区的方式来避免数据倾斜问题。此外,我们还可以通过设置分区的个数来平衡Map和Reduce的任务负载,这样可以减少任务的等待时间,提高整体的计算效率。

2. 调整内存相关参数

在MapReduce中,内存的使用是非常关键的。合理的内存配置不仅可以提高任务的处理速度,还可以减少I/O操作。我们可以通过调整MapTask和ReduceTask的内存上限以及CPU核心数来优化计算过程。例如,我们可以将MapTask和ReduceTask的内存上限设置为4G-6G,这样可以确保每个任务有足够的资源来处理数据。同时,我们还需要注意调整Shuffle阶段的内存参数,例如环形缓冲区的大小和溢出阈值,这些参数会影响Shuffle过程中的数据排序和合并效率。

3. 减少数据倾斜问题

数据倾斜是MapReduce中常见的问题之一,它会导致某些Reduce任务负担过重,而其他Reduce任务则处于空闲状态。为了避免数据倾斜,我们可以采取一些措施,例如使用抽样和范围分区的方式来预设分区边界值,或者通过自定义分区的方式来将数据均衡地分配给不同的Reduce任务。此外,我们还可以使用Combiner来提前聚合数据,减少Reduce阶段的工作负载。

4. 采用合适的数据压缩方式

在MapReduce中,数据压缩是一种常见的优化手段。它可以减少I/O操作和网络传输的时间。我们可以使用Snappy和LZO这两种压缩编码器来压缩数据。Snappy速度非常快,而且系统自带;LZO速度也不错,并且支持切片。通过采用数据压缩的方式,我们可以有效地减少IO的时间,提高整体的计算效率。

总结

综上所述,要有效利用MapReduce框架中的HashMap来优化数据处理,我们需要综合考虑多个方面的因素,包括合理的分区策略、内存资源配置、数据倾斜问题的处理以及数据压缩技术的应用。通过这些优化措施,我们可以大大提高MapReduce job的执行效率,降低计算成本。

相关文章