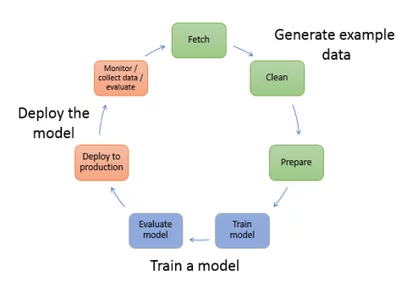

有效的训练和推理AIGC模型涉及多个层面的技术和策略,以下是一些关键点:

# 训练阶段

1. **算力与硬件**

– 使用高性能的GPU进行模型训练是必要的,尤其是对于大规模模型。例如,拥有16GB显存的GPU能够加载已经训练好的模型进行推理,但对于从零开始的预训练或微调,则需要更多的算力资源.

– 多机多卡并行训练时,需考虑网络IO等因素,以便高效地交换参数和梯度.

2. **数据准备**

– 数据质量比数据量更为重要。对于文本生成模型,可以通过爬取垂直领域的无标签语料进行训练,或使用现成的数据集进行微调.

– 使用SFT、RM、PPO等新的训练数据集范式,这有助于提升模型性能.

– 对于图片生成模型,需要大量的文本-图片对进行训练.

3. **模型微调与适配**

– **Finetune**:对于文本和图片生成,可以使用预训练模型进行微调。特别是文本生成,采用SFT、RM、RLHF的方式进行.

– **PEFT** (Parameter-Efficient Fine-Tuning):如LoRA方法,能够大幅减少显存占用,同时允许模型适应不同应用场景.

– **ICL** (In-context learning):无需进行梯度更新或微调,仅提供示例和任务描述即可.

# 推理阶段

– 对于推理任务,较低配置的硬件如7GB显卡的GPU也可能满足需求,特别是在使用PEFT等方法减少模型大小之后.

– 利用模型的API接口,即使本地算力有限,也能通过云端服务进行高效的推理.

# 技术工具

– 使用如PPDiffusers这样的深度学习框架,可以简化生成式AI模型的开发过程.

– 在训练过程中,注意数据预处理的重要性,包括数据的归一化、清洗和标注.

– 定期评估模型性能,并根据结果调整训练参数.

通过以上步骤,可以有效地训练和推理AIGC模型,从而最大化其性能和应用范围。

相关文章